هوش مصنوعی (AI) به یکی از بزرگترین عوامل تحول فناوری تبدیل شده است که صنایع را تحت تأثیر قرار داده و فرصتهای کاملاً جدیدی ایجاد می کند. از نقطه نظر مهندسی ، هوش مصنوعی فقط نوع پیشرفته تری از مهندسی داده است. بیشتر پروژه های هوش مصنوعی بیشتر شبیه کامیون های گل آلود هستند تا اتومبیل های مسابقه ای بی عیب و نقص - آنها یک فن آوری کار هستند که با فروتنی خط تولید را 5٪ ایمن تر می کند یا توصیه های فیلم را کمی بیشتر در مورد موضوعات نشان می دهد. با این حال ، بیش از بسیاری از فن آوری های دیگر ، بسیار آسان است که یک متخصص AI با حسن نیت ، وقتی قصد انجام کار خیر را دارد ، سهواً آسیب برساند. هوش مصنوعی این قدرت را دارد که تعصبات ناعادلانه را افزایش داده و تعصبات ذاتی را از لحاظ نمایی مضرتر کند.

ما به عنوان پزشکان هوش مصنوعی گوگل ، می فهمیم که نحوه توسعه و استفاده از فناوری هوش مصنوعی تا سالهای زیادی تأثیر بسزایی در جامعه خواهد داشت. به همین ترتیب ، تنظیم بهترین روش ها بسیار مهم است. این کار با توسعه مسئولانه این فناوری و کاهش تعصب احتمالی غیرمنصفانه ای که ممکن است وجود داشته باشد ، شروع می شود ، هر دو مورد نیاز به بیش از یک قدم پیش روی فناوری شناسان است: نه "آیا این اتوماسیون تحویل 15٪ در هزینه تحویل صرفه جویی می کند؟" اما "این تغییر چه تاثیری بر شهرهایی که ما در آن فعالیت می کنیم و افرادی - به ویژه جمعیت در معرض خطر - که در آنجا زندگی می کنند ، خواهد گذاشت؟"

این کار باید به روشی قدیمی انجام شود: با درک دانشمندان از داده های انسانی ، فرآیندی که متغیرهایی را ایجاد می کند که در مجموعه داده ها و مدل ها به وجود می آیند. علاوه بر این ، این تفاهم تنها در مشارکت با افرادی که توسط این متغیرها نمایندگی و تحت تأثیر قرار می گیرند ، حاصل می شود - اعضای جامعه و ذینفعان ، مانند کارشناسانی که سیستم های پیچیده ای را که AI در نهایت با آنها تعامل خواهد داشت ، درک می کنند.

فرضیات معلولی معیوب می تواند منجر به سوگیری ناعادلانه شود.

در واقع چگونه ما می توانیم این هدف از ایجاد انصاف را در این فن آوری های جدید پیاده کنیم - به خصوص وقتی که آنها اغلب به روشی کار می کنند که ما انتظار نداریم؟ به عنوان اولین قدم ، دانشمندان علوم کامپیوتر برای درک زمینه هایی که فناوری های آنها در حال توسعه و به کارگیری است ، باید کارهای بیشتری انجام دهند.

با وجود پیشرفت های ما در اندازه گیری و تشخیص سوگیری ناعادلانه ، اشتباهات علیت هنوز هم می تواند منجر به نتایج مضر برای جوامع حاشیه ای شود. اشتباه علیت چیست؟ به عنوان مثال مشاهده کنید که در قرون وسطی افراد بیمار شپش کمتری جذب می کنند ، که منجر به این می شود که شپش برای شما مفید است. در حقیقت ، شپش دوست ندارد در افراد تب دار زندگی کند. اشتباهات علتی از این قبیل ، که تصور می شود همبستگی به اشتباه علت و معلول را نشان می دهد ، می تواند در حوزه های پرمخاطره مانند مراقبت های بهداشتی و عدالت کیفری بسیار مضر باشد. توسعه دهندگان سیستم هوش مصنوعی - که معمولاً از سوابق علوم اجتماعی برخوردار نیستند - معمولاً سیستم ها و ساختارهای اساسی جامعه را که مشکلاتی را برای حل سیستم های آنها ایجاد می کند ، درک نمی کنند.

به عنوان مثال ، محققانی که کشف کردند که یک الگوریتم پزشکی که به طور گسترده در مراقبت های بهداشتی ایالات متحده مورد استفاده قرار می گیرد با تعصب نژادی نسبت به بیماران سیاه پوست است ، مشخص کردند که علت اصلی این فرض اشتباه علی است که توسط طراحان الگوریتم گفته شده است ، که افراد با نیازهای بهداشتی پیچیده تر پول بیشتری را صرف مراقبت های بهداشتی کرد. این فرض عوامل مهمی را نادیده می گیرد - مانند عدم اعتماد به سیستم مراقبت های بهداشتی و عدم دسترسی به مراقبت های بهداشتی ارزان قیمت - که صرف نظر از پیچیدگی نیازهای مراقبت های بهداشتی ، باعث کاهش هزینه های مراقبت های بهداشتی توسط بیماران سیاه پوست می شود.

محققان مرتباً این نوع اشتباه علیت و همبستگی را مرتکب می شوند. اما برای یک کامپیوتر یادگیرنده عمیق ، که میلیاردها همبستگی ممکن را جستجو می کند تا دقیق ترین روش برای پیش بینی داده ها را جستجو کند ، بدتر است و بنابراین میلیاردها فرصت برای اشتباهات علی وجود دارد. با پیچیدگی بیشتر این مسئله ، حتی با استفاده از ابزارهای مدرن ، مانند تجزیه و تحلیل Shapely ، درک اینکه چرا چنین اشتباهی مرتکب شده است بسیار دشوار است - یک دانشمند داده انسانی که با ابر رایانه خود در یک آزمایشگاه نشسته است ، هرگز نمی تواند از خود داده ها نتیجه بگیرد اشتباهات ممکن است باشد. به همین دلیل است که در میان دانشمندان ، هرگز قابل قبول نیست که ادعا کنیم فقط با نگاه منفعلانه به داده ها رابطه علیتی در طبیعت پیدا کرده ایم. شما باید فرضیه را فرموله کنید و سپس یک آزمایش انجام دهید تا علیت را تحریک کنید.

رسیدگی به این اشتباهات علیت نیاز به یک قدم به عقب دارد. دانشمندان علوم کامپیوتر برای درک و محاسبه زمینه های اساسی جامعه که این فناوری ها در آن توسعه یافته و به کار گرفته شده اند ، باید کارهای بیشتری انجام دهند.

در اینجا در گوگل ، ما شروع به پایه گذاری آنچه ممکن است این روش باشد ، می کنیم. در مقاله اخیربه طور مشترک توسط DeepMind ، Google AI و تیم اعتماد و ایمنی ما نوشته شده است ، ما استدلال می کنیم که توجه به این زمینه های اجتماعی مستلزم پذیرش این واقعیت است که سیستم های انطباقی پویا ، پیچیده ، غیرخطی هستند و با مکانیزم های بازخورد قابل مشاهده اداره می شوند. همه ما در این سیستم ها شرکت می کنیم ، اما هیچ فرد یا الگوریتمی نمی تواند آنها را به طور کامل ببیند یا آنها را درک کند. بنابراین ، برای محاسبه این نقاط کور اجتناب ناپذیر و نوآوری با مسئولیت پذیری نوآورانه ، تکنسین ها باید با ذینفعان - نمایندگان جامعه شناسی ، علوم رفتاری و علوم انسانی و همچنین جوامع آسیب پذیر همکاری کنند تا فرضیه مشترکی در مورد نحوه کار آنها تشکیل دهند.

این رویکرد مشارکتی برای درک سیستم های پیچیده اجتماعی - به نام دینامیک سیستم مبتنی بر جامعه (CBSD) - مستلزم ایجاد شبکه های جدید برای وارد کردن این ذینفعان به فرآیند است. CBSD مبتنی بر تفکر سیستمی است و شامل روشهای کمی و کیفی دقیق برای توصیف مشترک و درک حوزه های پیچیده مشکل است ، و ما آن را به عنوان یک روش امیدوار کننده در تحقیقات خود شناسایی کرده ایم. ایجاد ظرفیت برای همکاری با جوامع به روشهای منصفانه و اخلاقی که منافع را برای همه شرکت کنندگان فراهم می کند ، باید از اولویت های اصلی باشد. آسان نخواهد بود اما بینش های جامعه به دست آمده از درک عمیق از مشکلاتی که بیشترین آسیب را برای آسیب پذیرترین افراد جامعه دارند ، می تواند منجر به نوآوری های فناوری شود که برای همه ایمن تر و سودمندتر باشد.

تغییر از ذهنیت "ساختن چون می توانیم" به "ساختن آنچه که باید" هستیم.

وقتی جوامع در فرآیند طراحی توسعه محصول کمتر از نمایندگی برخوردار می شوند ، محصولاتی که نتیجه می گیرند کمتر مورد توجه قرار می گیرند. در حال حاضر ، ما در حال طراحی هستیم که آینده هوش مصنوعی چگونه خواهد بود. آیا فراگیر و عادلانه خواهد بود؟ یا منعکس کننده ترین و ناعادلانه ترین عناصر جامعه ما خواهد بود؟ گزینه عادلانه تر ، یک نتیجه گیری قبلی نیست - ما باید به دنبال آن باشیم. چشم انداز ما برای این فناوری دیدگاهی است که طیف کاملی از دیدگاه ها ، تجربیات و نابرابری های ساختاری برای آن حساب شود. ما تلاش می کنیم تا این دیدگاه ها را به طرق مختلفی جستجو کنیم ، از جمله فرایندهای اهتمام به حقوق بشر ، دوزهای تحقیقاتی ، ورودی مستقیم از جوامع آسیب پذیر و سازمان هایی که متمرکز بر شمول ، تنوع و برابری مانند WiML (زنان در ML) وLatinx در AI؛ بسیاری از این سازمانها همچنین توسط محققان گوگلر ، مانند سیاه و سفید در هوش مصنوعی و کوئر در هوش مصنوعی ، بنیان گذاشته شده و تحت رهبری آنها هستند .

اگر ما ، به عنوان یک رشته ، می خواهیم این فناوری مطابق با ایده آل های ما باشد ، پس باید نحوه تفکر درباره آنچه را که می سازیم تغییر دهیم - تا از "ساختن چون می توانیم" به ذهنیت خود برویم و "آنچه را که باید بسازیم" " این به معنای تغییر اساسی تمرکز ما به درک مشکلات عمیق و کار در جهت اخلاق اخلاقی و همکاری با جوامع حاشیه ای است. این امر هم از داده هایی که به الگوریتم های ما دامن می زند و هم از مشکلاتی که به دنبال حل آنها هستیم ، دید مطمئن تری به ما می دهد. این درک عمیق تر می تواند به سازمانها در هر بخش اجازه دهد امکانات جدیدی را که ارائه می دهند در عین فراگیر بودن ، برابری و سودمندی اجتماعی باز کند.

مطالب:

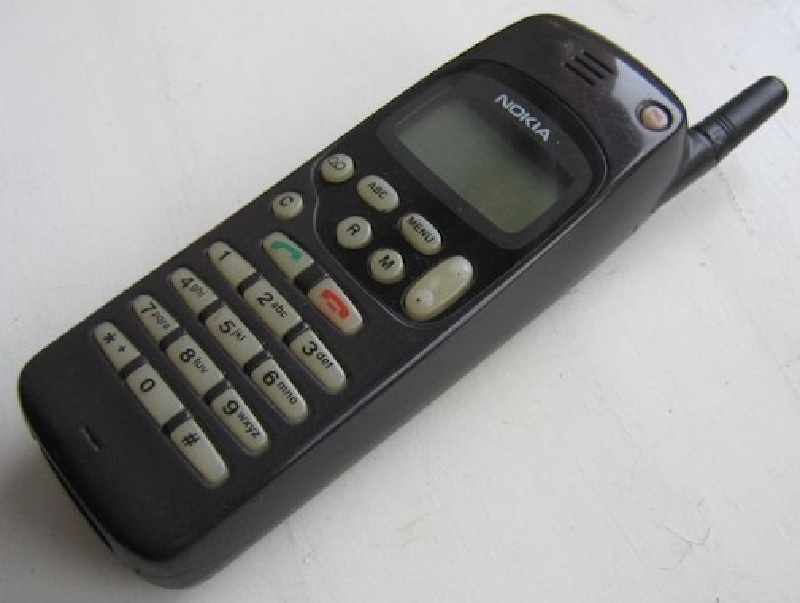

تاریخچه تولید تلفن های هوشمند که از بزرگترین و مهم ترین تکنولوژی های دنیا می باشند

آشنایی با تکنولوژی عملکرد قطعات ماشین لباسشویی

آیفون 6s یا آیفون 7! کدام را می پسندید؟!

نحوه به روزرسانی سیستم اندروید

هوش مصنوعی (AI) به یکی از بزرگترین عوامل تحول فناوری تبدیل شده است که صنایع را تحت تأثیر قرار داده و فرصتهای کاملاً جدیدی ایجاد می کند. از نقطه نظر مهندسی ، هوش مصنوعی فقط نوع پیشرفته تری از مهندسی داده است. بیشتر پروژه های هوش مصنوعی بیشتر شبیه کامیون های گل آلود هستند تا اتومبیل های مسابقه ای بی عیب و نقص - آنها یک فن آوری کار هستند که با فروتنی خط تولید را 5٪ ایمن تر می کند یا توصیه های فیلم را کمی بیشتر در مورد موضوعات نشان می دهد. با این حال ، بیش از بسیاری از فن آوری های دیگر ، بسیار آسان است که یک متخصص AI با حسن نیت ، وقتی قصد انجام کار خیر را دارد ، سهواً آسیب برساند. هوش مصنوعی این قدرت را دارد که تعصبات ناعادلانه را افزایش داده و تعصبات ذاتی را از لحاظ نمایی مضرتر کند.

ما به عنوان پزشکان هوش مصنوعی گوگل ، می فهمیم که نحوه توسعه و استفاده از فناوری هوش مصنوعی تا سالهای زیادی تأثیر بسزایی در جامعه خواهد داشت. به همین ترتیب ، تنظیم بهترین روش ها بسیار مهم است. این کار با توسعه مسئولانه این فناوری و کاهش تعصب احتمالی غیرمنصفانه ای که ممکن است وجود داشته باشد ، شروع می شود ، هر دو مورد نیاز به بیش از یک قدم پیش روی فناوری شناسان است: نه "آیا این اتوماسیون تحویل 15٪ در هزینه تحویل صرفه جویی می کند؟" اما "این تغییر چه تاثیری بر شهرهایی که ما در آن فعالیت می کنیم و افرادی - به ویژه جمعیت در معرض خطر - که در آنجا زندگی می کنند ، خواهد گذاشت؟"

این کار باید به روشی قدیمی انجام شود: با درک دانشمندان از داده های انسانی ، فرآیندی که متغیرهایی را ایجاد می کند که در مجموعه داده ها و مدل ها به وجود می آیند. علاوه بر این ، این تفاهم تنها در مشارکت با افرادی که توسط این متغیرها نمایندگی و تحت تأثیر قرار می گیرند ، حاصل می شود - اعضای جامعه و ذینفعان ، مانند کارشناسانی که سیستم های پیچیده ای را که AI در نهایت با آنها تعامل خواهد داشت ، درک می کنند.

فرضیات معلولی معیوب می تواند منجر به سوگیری ناعادلانه شود.

در واقع چگونه ما می توانیم این هدف از ایجاد انصاف را در این فن آوری های جدید پیاده کنیم - به خصوص وقتی که آنها اغلب به روشی کار می کنند که ما انتظار نداریم؟ به عنوان اولین قدم ، دانشمندان علوم کامپیوتر برای درک زمینه هایی که فناوری های آنها در حال توسعه و به کارگیری است ، باید کارهای بیشتری انجام دهند.

با وجود پیشرفت های ما در اندازه گیری و تشخیص سوگیری ناعادلانه ، اشتباهات علیت هنوز هم می تواند منجر به نتایج مضر برای جوامع حاشیه ای شود. اشتباه علیت چیست؟ به عنوان مثال مشاهده کنید که در قرون وسطی افراد بیمار شپش کمتری جذب می کنند ، که منجر به این می شود که شپش برای شما مفید است. در حقیقت ، شپش دوست ندارد در افراد تب دار زندگی کند. اشتباهات علتی از این قبیل ، که تصور می شود همبستگی به اشتباه علت و معلول را نشان می دهد ، می تواند در حوزه های پرمخاطره مانند مراقبت های بهداشتی و عدالت کیفری بسیار مضر باشد. توسعه دهندگان سیستم هوش مصنوعی - که معمولاً از سوابق علوم اجتماعی برخوردار نیستند - معمولاً سیستم ها و ساختارهای اساسی جامعه را که مشکلاتی را برای حل سیستم های آنها ایجاد می کند ، درک نمی کنند.

به عنوان مثال ، محققانی که کشف کردند که یک الگوریتم پزشکی که به طور گسترده در مراقبت های بهداشتی ایالات متحده مورد استفاده قرار می گیرد با تعصب نژادی نسبت به بیماران سیاه پوست است ، مشخص کردند که علت اصلی این فرض اشتباه علی است که توسط طراحان الگوریتم گفته شده است ، که افراد با نیازهای بهداشتی پیچیده تر پول بیشتری را صرف مراقبت های بهداشتی کرد. این فرض عوامل مهمی را نادیده می گیرد - مانند عدم اعتماد به سیستم مراقبت های بهداشتی و عدم دسترسی به مراقبت های بهداشتی ارزان قیمت - که صرف نظر از پیچیدگی نیازهای مراقبت های بهداشتی ، باعث کاهش هزینه های مراقبت های بهداشتی توسط بیماران سیاه پوست می شود.

محققان مرتباً این نوع اشتباه علیت و همبستگی را مرتکب می شوند. اما برای یک کامپیوتر یادگیرنده عمیق ، که میلیاردها همبستگی ممکن را جستجو می کند تا دقیق ترین روش برای پیش بینی داده ها را جستجو کند ، بدتر است و بنابراین میلیاردها فرصت برای اشتباهات علی وجود دارد. با پیچیدگی بیشتر این مسئله ، حتی با استفاده از ابزارهای مدرن ، مانند تجزیه و تحلیل Shapely ، درک اینکه چرا چنین اشتباهی مرتکب شده است بسیار دشوار است - یک دانشمند داده انسانی که با ابر رایانه خود در یک آزمایشگاه نشسته است ، هرگز نمی تواند از خود داده ها نتیجه بگیرد اشتباهات ممکن است باشد. به همین دلیل است که در میان دانشمندان ، هرگز قابل قبول نیست که ادعا کنیم فقط با نگاه منفعلانه به داده ها رابطه علیتی در طبیعت پیدا کرده ایم. شما باید فرضیه را فرموله کنید و سپس یک آزمایش انجام دهید تا علیت را تحریک کنید.

رسیدگی به این اشتباهات علیت نیاز به یک قدم به عقب دارد. دانشمندان علوم کامپیوتر برای درک و محاسبه زمینه های اساسی جامعه که این فناوری ها در آن توسعه یافته و به کار گرفته شده اند ، باید کارهای بیشتری انجام دهند.

در اینجا در گوگل ، ما شروع به پایه گذاری آنچه ممکن است این روش باشد ، می کنیم. در مقاله اخیربه طور مشترک توسط DeepMind ، Google AI و تیم اعتماد و ایمنی ما نوشته شده است ، ما استدلال می کنیم که توجه به این زمینه های اجتماعی مستلزم پذیرش این واقعیت است که سیستم های انطباقی پویا ، پیچیده ، غیرخطی هستند و با مکانیزم های بازخورد قابل مشاهده اداره می شوند. همه ما در این سیستم ها شرکت می کنیم ، اما هیچ فرد یا الگوریتمی نمی تواند آنها را به طور کامل ببیند یا آنها را درک کند. بنابراین ، برای محاسبه این نقاط کور اجتناب ناپذیر و نوآوری با مسئولیت پذیری نوآورانه ، تکنسین ها باید با ذینفعان - نمایندگان جامعه شناسی ، علوم رفتاری و علوم انسانی و همچنین جوامع آسیب پذیر همکاری کنند تا فرضیه مشترکی در مورد نحوه کار آنها تشکیل دهند.

این رویکرد مشارکتی برای درک سیستم های پیچیده اجتماعی - به نام دینامیک سیستم مبتنی بر جامعه (CBSD) - مستلزم ایجاد شبکه های جدید برای وارد کردن این ذینفعان به فرآیند است. CBSD مبتنی بر تفکر سیستمی است و شامل روشهای کمی و کیفی دقیق برای توصیف مشترک و درک حوزه های پیچیده مشکل است ، و ما آن را به عنوان یک روش امیدوار کننده در تحقیقات خود شناسایی کرده ایم. ایجاد ظرفیت برای همکاری با جوامع به روشهای منصفانه و اخلاقی که منافع را برای همه شرکت کنندگان فراهم می کند ، باید از اولویت های اصلی باشد. آسان نخواهد بود اما بینش های جامعه به دست آمده از درک عمیق از مشکلاتی که بیشترین آسیب را برای آسیب پذیرترین افراد جامعه دارند ، می تواند منجر به نوآوری های فناوری شود که برای همه ایمن تر و سودمندتر باشد.

تغییر از ذهنیت "ساختن چون می توانیم" به "ساختن آنچه که باید" هستیم.

وقتی جوامع در فرآیند طراحی توسعه محصول کمتر از نمایندگی برخوردار می شوند ، محصولاتی که نتیجه می گیرند کمتر مورد توجه قرار می گیرند. در حال حاضر ، ما در حال طراحی هستیم که آینده هوش مصنوعی چگونه خواهد بود. آیا فراگیر و عادلانه خواهد بود؟ یا منعکس کننده ترین و ناعادلانه ترین عناصر جامعه ما خواهد بود؟ گزینه عادلانه تر ، یک نتیجه گیری قبلی نیست - ما باید به دنبال آن باشیم. چشم انداز ما برای این فناوری دیدگاهی است که طیف کاملی از دیدگاه ها ، تجربیات و نابرابری های ساختاری برای آن حساب شود. ما تلاش می کنیم تا این دیدگاه ها را به طرق مختلفی جستجو کنیم ، از جمله فرایندهای اهتمام به حقوق بشر ، دوزهای تحقیقاتی ، ورودی مستقیم از جوامع آسیب پذیر و سازمان هایی که متمرکز بر شمول ، تنوع و برابری مانند WiML (زنان در ML) وLatinx در AI؛ بسیاری از این سازمانها همچنین توسط محققان گوگلر ، مانند سیاه و سفید در هوش مصنوعی و کوئر در هوش مصنوعی ، بنیان گذاشته شده و تحت رهبری آنها هستند .

اگر ما ، به عنوان یک رشته ، می خواهیم این فناوری مطابق با ایده آل های ما باشد ، پس باید نحوه تفکر درباره آنچه را که می سازیم تغییر دهیم - تا از "ساختن چون می توانیم" به ذهنیت خود برویم و "آنچه را که باید بسازیم" " این به معنای تغییر اساسی تمرکز ما به درک مشکلات عمیق و کار در جهت اخلاق اخلاقی و همکاری با جوامع حاشیه ای است. این امر هم از داده هایی که به الگوریتم های ما دامن می زند و هم از مشکلاتی که به دنبال حل آنها هستیم ، دید مطمئن تری به ما می دهد. این درک عمیق تر می تواند به سازمانها در هر بخش اجازه دهد امکانات جدیدی را که ارائه می دهند در عین فراگیر بودن ، برابری و سودمندی اجتماعی باز کند.

مطالب:

۴ تا از بهترین لپ تاپ های گیمینگ ایسوس که باید بشناسید!

۴ تا از بهترین لپ تاپ های گیمینگ ایسوس که باید بشناسید! بهترین گوشی های 2022 شیائومی

بهترین گوشی های 2022 شیائومی بهترین دوربین بدون آینه 2022

بهترین دوربین بدون آینه 2022 راه اندازی سیستم تصفیه آب صنعتی چگونه است؟

راه اندازی سیستم تصفیه آب صنعتی چگونه است؟ بهترین فناوری تلوزیون های 2020

بهترین فناوری تلوزیون های 2020 ساعت مکانیکی از دسته تکنولوژی های محبوب | نحوه ساخت

ساعت مکانیکی از دسته تکنولوژی های محبوب | نحوه ساخت تاریخچه تولید تلفن های هوشمند که از بزرگترین و مهم ترین تکنولوژی های دنیا می باشند

تاریخچه تولید تلفن های هوشمند که از بزرگترین و مهم ترین تکنولوژی های دنیا می باشند نکات برتر در مورد نحوه ساخت برنامه چت خود

نکات برتر در مورد نحوه ساخت برنامه چت خود